Covid-19: KI produziert Datenmüll

Die Ergebnisse von Anwendungen Künstlicher Intelligenz (KI) sind schwierig zu evaluieren. Es scheint, dass einige Unternehmen, wie das von dem CDU Politiker Philipp Amthor lobbyierte Augustus Intelligence nur aus geschickter Public Relation besteht. Es soll, so das Handelsblatt „kein Produkt, keine Kunden und keine Umsätze“ haben.

Das Allen Institute for Artificial Intelligence (AI2), das vom verstorbenen Microsoft-Mitbegründer Paul Allen gegründet wurde und KI-Systeme mit Argumentations-, Lern und Lesefähigkeiten konstruiert, präsentiert SCIFACT, das Fachliteratur zu Covid-19 automatisch klassifizieren soll. Eine Anwendung, die für das Information Retrieval von größtem Interesse sein könnte.

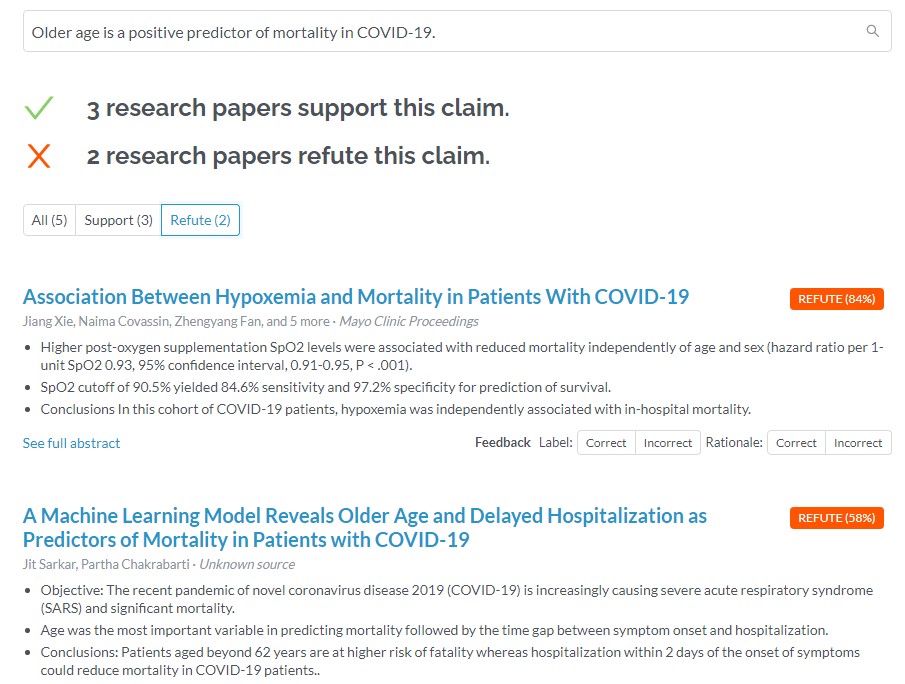

“About our model: Our system is designed as a research tool to help scientists identify relevant findings in the research literature. It is NOT designed to detect misinformation or disinformation in the news or social media…. Our system can assess whether a scientific paper provides evidence supporting or refuting a scientific claim.” In dem Preprint “Fact or Fiction: Verifying Scientific Claims” auf arxiv.org wird das Verfahren erläutert.

Analysieren wir die einzelnen Komponente von SCIFACT:

Datenbasis

– Wikipedia

Es wird nicht dargestellt, welche Daten aus Wikipedia übernommen werden. Aufgrund der sozialen Konstruktion von Wikipedia und der unterschiedlichen Qualität der Artikel ist eine kritische Prüfung auf Plausibilität, Vollständigkeit und Objektivität an externen Quellen immer erforderlich. Der Verweis auf FEVER (a large-scale dataset for Fact Extraction and VERification), das Wikipedia-immanent Sätze abprüft, reicht nicht aus.

– Abstracts von S2ORC-Artikeln

Eine Auswahl von Open Source Artikeln in S2ORC (The Semantic Scholar Open Research Corpus) , die aus zuverlässigen Quellen stammen und mindestens 10 Zitierungen aufweisen.

Mit Hilfe studentischer Hilfskräfte werden aus diesen Artikeln Behauptungen (Claims) extrahiert und nach SUPPORTS, REFUTES, NOINFO einer Behauptung klassifiziert.

Abgesehen von der fachlichen Kompetenz der studentischen Hilfskräfte werden statisch die Aussagen der Wissenschaftsparadigmen eines bestimmten Zeitpunkts festgehalten. Nicht zuletzt der Wissenszuwachs zu Covid-19 verdeutlicht die Problematik des Vorgehens. Zusätzlich erfolgt eine Komplexitätsreduktion wissenschaftlicher Analyse und Diskurs durch Klassifikation auf 3 Elemente: Zustimmung, Ablehnung, Neutral.

Verfahren

Anschließend prüft ein neuronales Netzwerk die Claims gegen Abstracts, also nicht den Volltext, der Fachliteratur. Während in der dokumentarischen Arbeit der Fachdatenbank das Abstract mit DIN und ISO-Normen eine kurze, genaue und neutrale Wiedergabe des Inhalts gewährleistet, steht im wissenschaftlichen Abstract die Funktionserfüllung im Zentrum: der intendierte Adressat soll entscheiden, ob er den Originaltext lesen sollte, muss also eine kommunikative Funktion innerhalb der wissenschaftlichen Zielgruppe erfüllen.

Ergebnis

Bewertung

Bei dieser Art von Fact Checking handelt es sich um ein komplexes semantisches Problem. Ausgehend von einer fragwürdigen Datenbasis und normativen Festlegungen soll mit pattern matching zweier Textsorten eine inhaltliche Relevanz erzielt werden. Was soll z.B. eine derartige 58%ige Übereinstimmung für wissenschaftliche Relevanz bedeuten?

„Insofern kann die Arbeit als erster Beleg für die Machbarkeit eines KI-basierten Systems für Fakten-Checks gelten“, jubeln die IT-Nerds von Heise. Dies lässt das Schlimmste für zukünftige Evaluationen von KI-Anwendungen befürchten. Denn was hier produziert wird, ist Datenmüll.

Weitere Links zu SCIFACT:

https://www.heise.de/news/KI-Werkzeug-soll-Fachliteratur-zu-Covid-19-automatisch-einschaetzen-4772788.html

https://www.technologyreview.com/2020/05/29/1002349/ai-coronavirus-scientific-fact-checking/

https://theusbreakingnews.com/allen-institutes-verisci-uses-ai-to-fact-check-scientific-claims/

https://venturebeat.com/2020/05/04/allen-institutes-verisci-uses-ai-to-fact-check-scientific-claims/